Robots.txt Checker 是一款重要工具,旨在确保网站 robots.txt 文件的效率、准确性和有效性。

cmlabs 的 Robots.txt Checker 是您管理网站 robots.txt 文件基本方面的终极工具。该工具专为网站所有者和开发人员量身定制,简化了与维护健康的 robots.txt 配置相关的通常复杂的任务。

只需点击几下,您就可以确保正确设置指令以有效地引导搜索引擎爬虫。该工具可以快速验证您的 robots.txt 指令是否适当阻止或允许特定 URL。让我们来控制您网站的索引指令。立即下载并尝试!

特点和优点

- 该工具免费提供。

- 检查被阻止的 URL:帮助您验证网站上的特定 URL 是否被 robots.txt 文件阻止。

- 阻止语句的识别:这些语句是包含搜索引擎不索引或访问网站上的特定页面或目录的指令的规则。

- 检查站点地图文件:sitemap.xml 文件是增强站点在搜索引擎中的可见性的重要文档。

如何使用

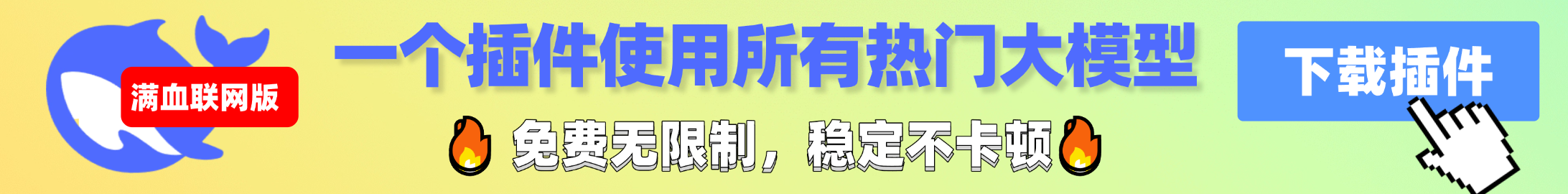

1.打开Robots.txt检查器

您可以继续选择 Robots.txt 检查器工具开始分析 URL 并检查其中的 robots.txt 或 sitemap.xml 文件。

2. 输入网址

要启动审核过程,只需输入 URL,如工具页面顶部蓝色框中的示例所示。为了顺利进行审核过程,请确保您输入的 URL 遵循格式:https://www.example.com。

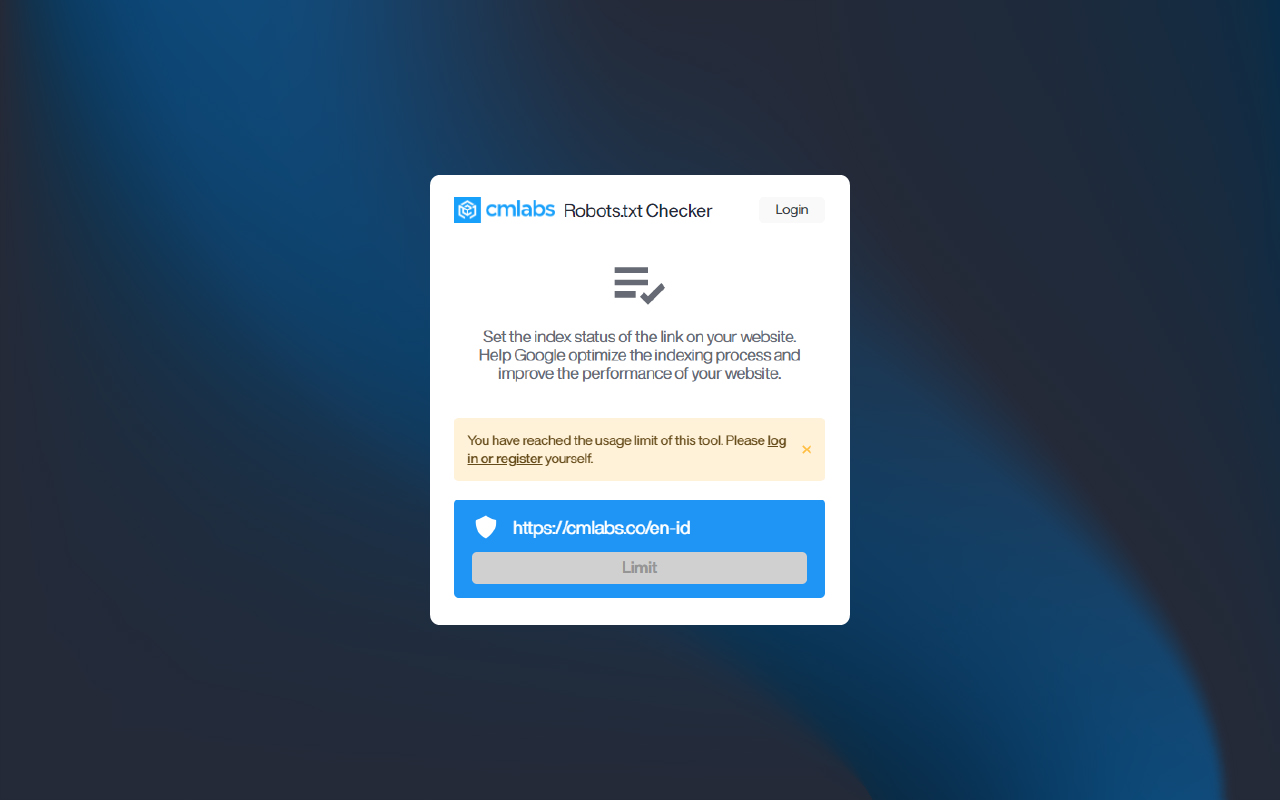

3. 启动审核流程

输入 URL 后,您将看到几个按钮,包括“检查来源”、选择机器人类型以及通过“检查 URL”按钮检查 URL。请注意,您在 1 小时内最多只能审核网址 5 次。

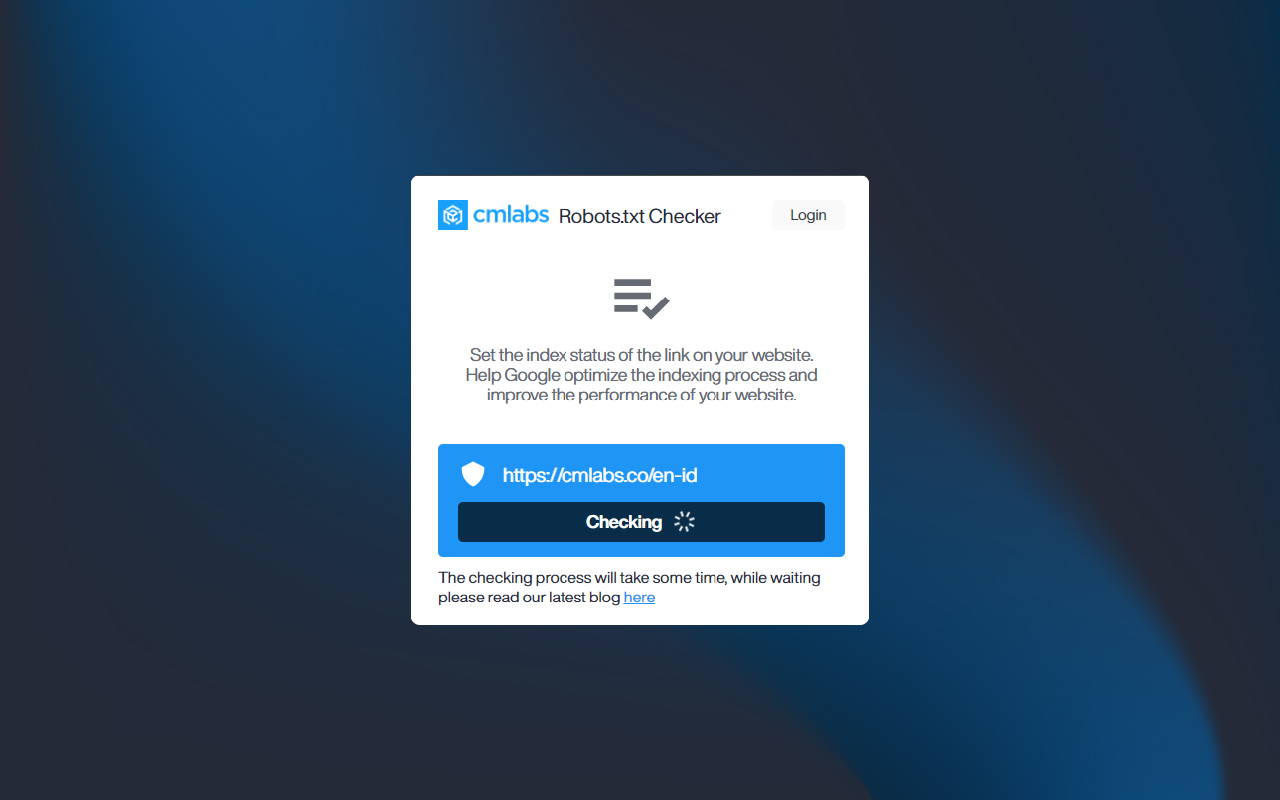

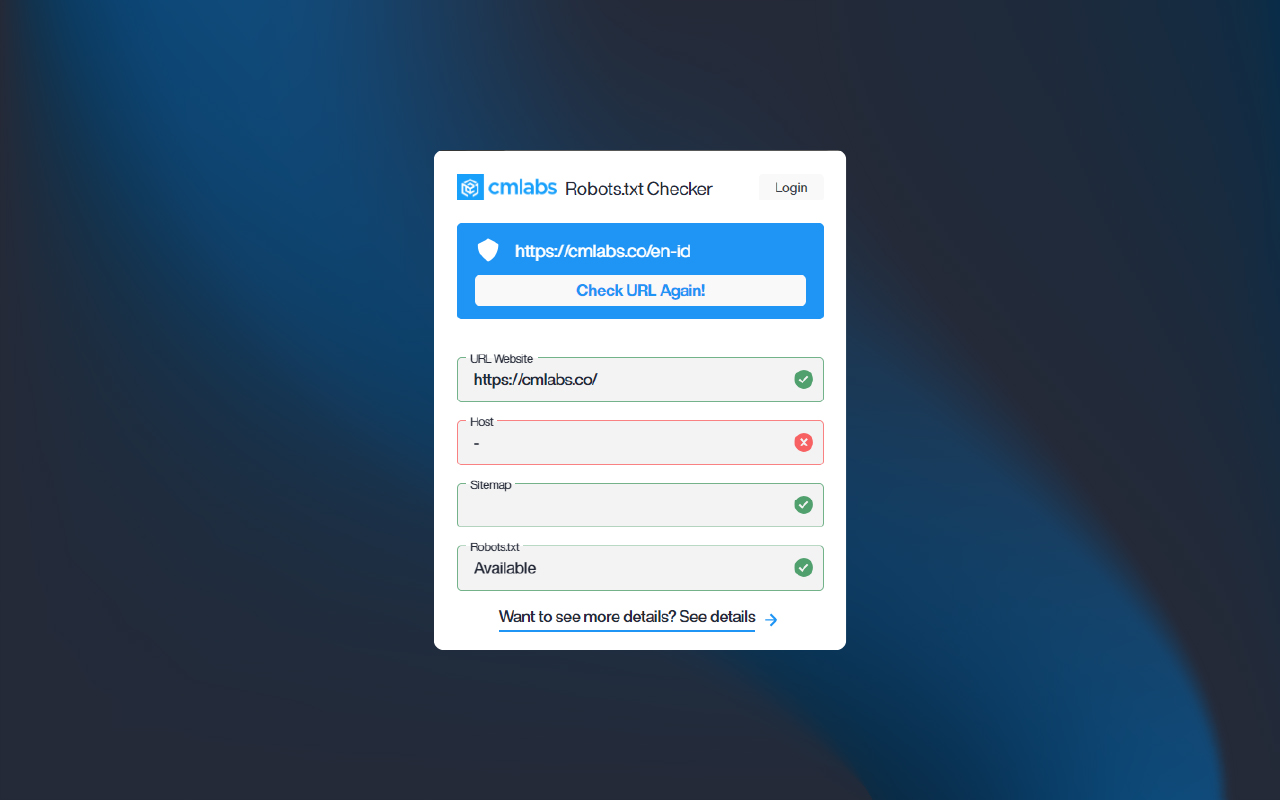

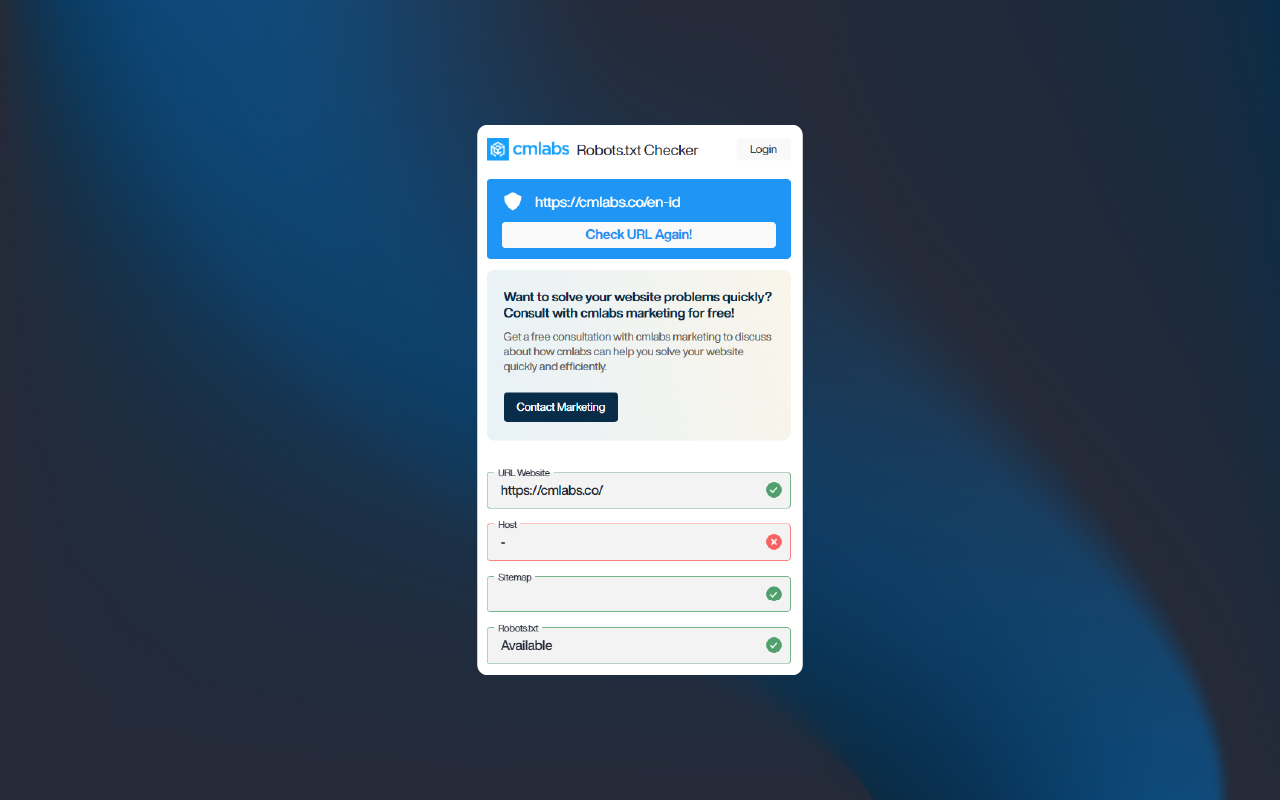

4. 分析数据

审核过程完成后,您将看到显示多条信息的结果,包括:

- 网站网址

- 主持人

- 网站地图

- Robots.txt 文件

帮助与支持

我们重视您的反馈!如果您对改进 Robots.txt Checker 有任何建议或在使用该工具时遇到任何问题,请随时告诉我们。我们的支持团队随时为您提供帮助。通过电子邮件联系我们:

营销@cmlabs.co

dev@cmlabs.co