Robots Exclusion Checker

介绍

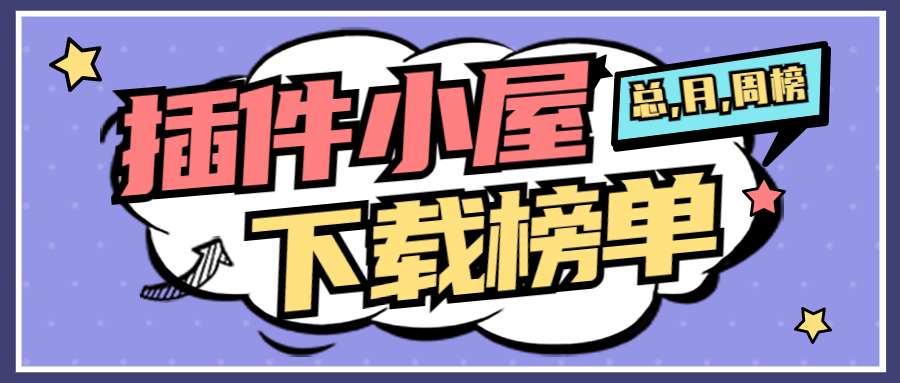

机器人排除检查器旨在直观地指示是否有任何机器人排除阻止您的页面被搜索引擎抓取或索引。

## 扩展报告 5 个元素:

1.机器人.txt

2.元机器人标签

3. X-robots-标签

4.Rel=规范

5. UGC、Sponsored 和 Nofollow 属性值

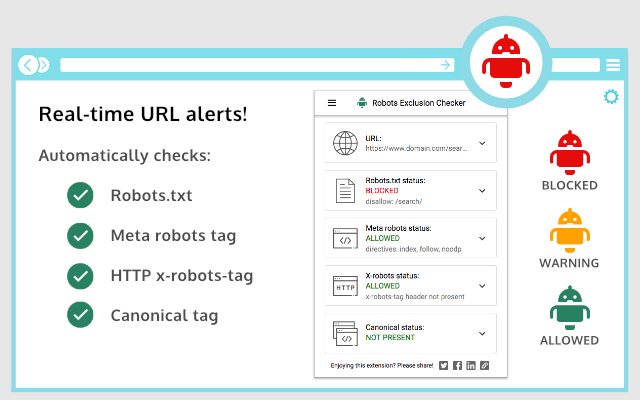

- 机器人.txt

如果您访问的 URL 受到 robots.txt 中的“允许”或“禁止”的影响,扩展程序将在扩展程序中向您显示特定规则,以便轻松复制或访问实时 robots.txt。您将还会显示完整的 robots.txt,其中突出显示了特定规则(如果适用)。酷啊!

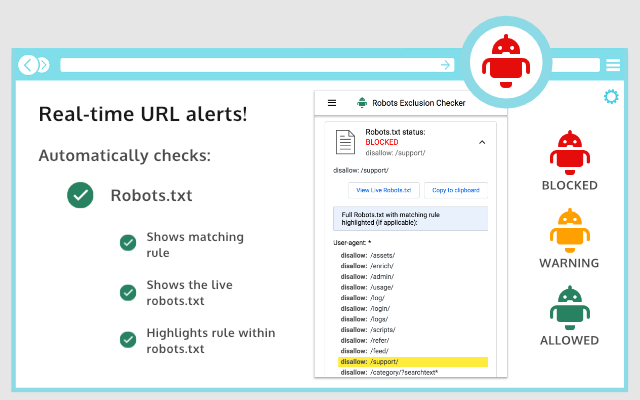

- 元机器人标签

任何将机器人引导至“index”、“noindex”、“follow”或“nofollow”的机器人元标签将标记相应的红色、琥珀色或绿色图标。不会影响搜索引擎索引的指令,例如“nosnippet”或“noodp”,将显示但不会被纳入警报。该扩展使查看所有指令变得容易,并向您显示源代码中出现的所有 HTML 元机器人标签。

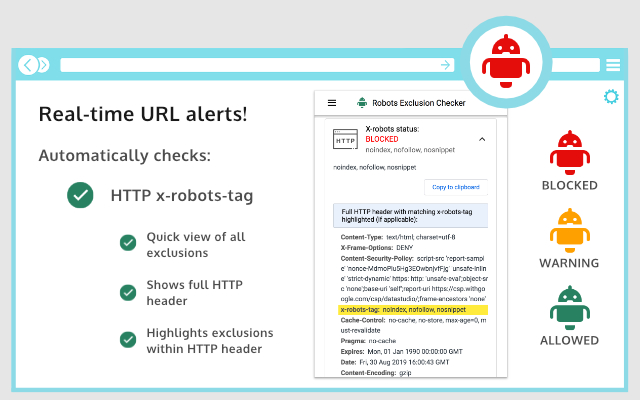

- X-机器人标签

在过去,在 HTTP 标头中发现任何机器人指令有点痛苦,但现在有了这个扩展。任何特定的排除项以及完整的 HTTP 标头都将非常明显 - 特定的排除项也会突出显示!

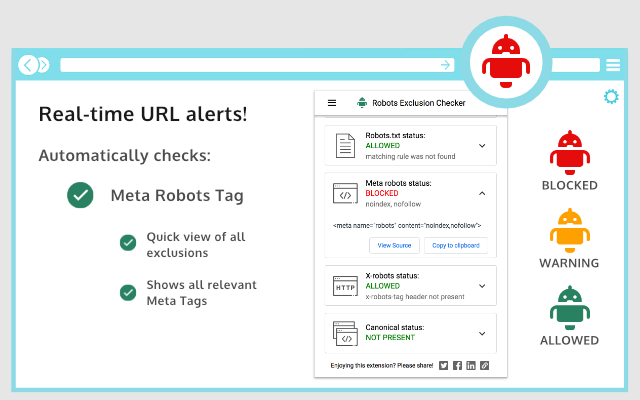

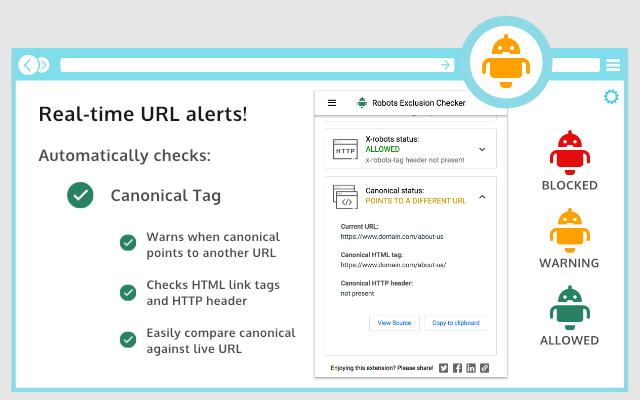

- 规范标签

尽管规范标签不会直接影响索引,但它仍然会影响您的 URL 在 SERPS(搜索引擎结果页面)中的行为方式。如果您正在查看的页面允许机器人访问但检测到规范不匹配(当前 URL 与规范 URL 不同),则扩展程序将标记一个琥珀色图标。规范信息是从 HTML <head> 和 HTTP 标头响应中的每个页面上收集的。

- UGC、赞助和 Nofollow

扩展的新增功能使您可以选择突出显示使用“nofollow”、“ugc”或“sponsored”rel 属性值的任何可见链接。您可以控制突出显示哪些链接并为每个链接设置您喜欢的颜色。我希望您将其禁用,您可以完全关闭。

## 用户代理

在设置中,您可以选择以下用户代理之一来模拟每个搜索引擎可以访问的内容:

1.谷歌机器人

2. 谷歌机器人新闻

3.必应

4. 雅虎

## 好处

此工具对从事搜索引擎优化 (SEO) 或数字营销的任何人都非常有用,因为如果页面被 robots.txt 阻止,它会提供清晰的视觉指示(许多现有扩展程序不会标记此)。抓取或索引问题直接影响您的网站在有机结果中的表现,因此此扩展程序应该成为您的 Google Chrome 搜索引擎优化开发人员工具包的一部分。在线提供的一些常见 robots.txt 测试器的替代品。

此扩展适用于:

- 分面导航审查和优化(有助于查看复杂/堆叠面背后的机器人控制)

- 检测爬网或索引问题

- 在您的浏览器中进行一般 SEO 审查和审核

## 避免需要多个 SEO 扩展

在机器人和索引化领域,没有更好的扩展可用。事实上,通过安装 Robots Exclusion Checker,您将避免在 Chrome 中运行多个会减慢其功能的扩展程序。

类似的插件包括:

不关注

https://chrome.google.com/webstore/detail/nofollow/dfogidghaigoomjdeacndafapdijmiid

机器人

https://chrome.google.com/webstore/detail/seerobots/hnljoiodjfgpnddiekagpbblnjedcnfp

NoIndex,NoFollow 元标签检查器

https://chrome.google.com/webstore/detail/noindexnofollow-meta-tag/aijcgkcgldkomeddnlpbhdelcpfamklm

变更日志:

1.0.2:修复了阻止元机器人在 URL 更新后更新的错误。

1.0.3:各种错误修复,包括更好地处理带有编码字符的 URL。 Robots.txt 扩展功能允许查看超长规则。现在 JavaScript history.pushState() 兼容。

1.0.4:各种升级。添加了带有琥珀色图标警报的规范标签检测(HTML 和 HTTP 标头)。 Robots.txt 现在已完整显示,并突出显示了相应的规则。 X-robots-tag 现在在完整的 HTTP 标头信息中突出显示。各种用户体验改进,例如“复制到剪贴板”和“查看源代码”链接。添加了社交分享图标。

1.0.5:当扩展检测到 URL 更改但没有新的 HTTP 标头信息时,强制调用后台 HTTP 标头 - 主要用于严重依赖 JavaScript 的站点。

1.0.6:修复了在进行规范检查时 URL 哈希部分的问题。

1.0.7:除了 HTTP 标头之外,还强制执行后台正文响应调用,以确保 JavaScript 重度站点的 URL 的非缓存视图。

1.0.8:修复了在 robots.txt 文件中检测到对同一用户代理的多个引用时发生的错误。

1.0.9:修复了规范不匹配警报的问题。

1.1.0:各种 UI 更新,包括当扩展检测到没有新 HTTP 请求的 URL 更改时的 JavaScript 警报。

1.1.1:添加了额外的逻辑元机器人用户代理规则冲突。

1.1.2:添加了德语用户界面。

1.1.3:添加了 UGC、赞助商和 Nofollow 链接突出显示。

1.1.4:在新安装时默认关闭 nofollow 链接突出显示,并修复了与 HTTP 标头规范不匹配相关的错误。

1.1.5:错误修复以改进 robots.txt 解析器。

1.1.6:扩展现在用红色标记 404 错误。

1.1.7:在发出后台请求以获取使用 pushstate 导航到的页面时不发送 cookie。

1.1.8:改进相对与绝对规范 URL 和未编码 URL 消息的处理。

发现错误或想提出建议?请发送电子邮件至 extensions @samgipson.com