全面的SEO分析工具揭示了搜索引擎在您的页面上看到的内容

SEO X射线:完整的技术SEO视觉工具

通过您的网页查看,例如带有功能强大的视觉指示器的搜索引擎。立即了解可能会损害您排名的索引性,爬行性和技术SEO问题。

✅一目了然的全面SEO分析

-----------------------------------------------------------------------------

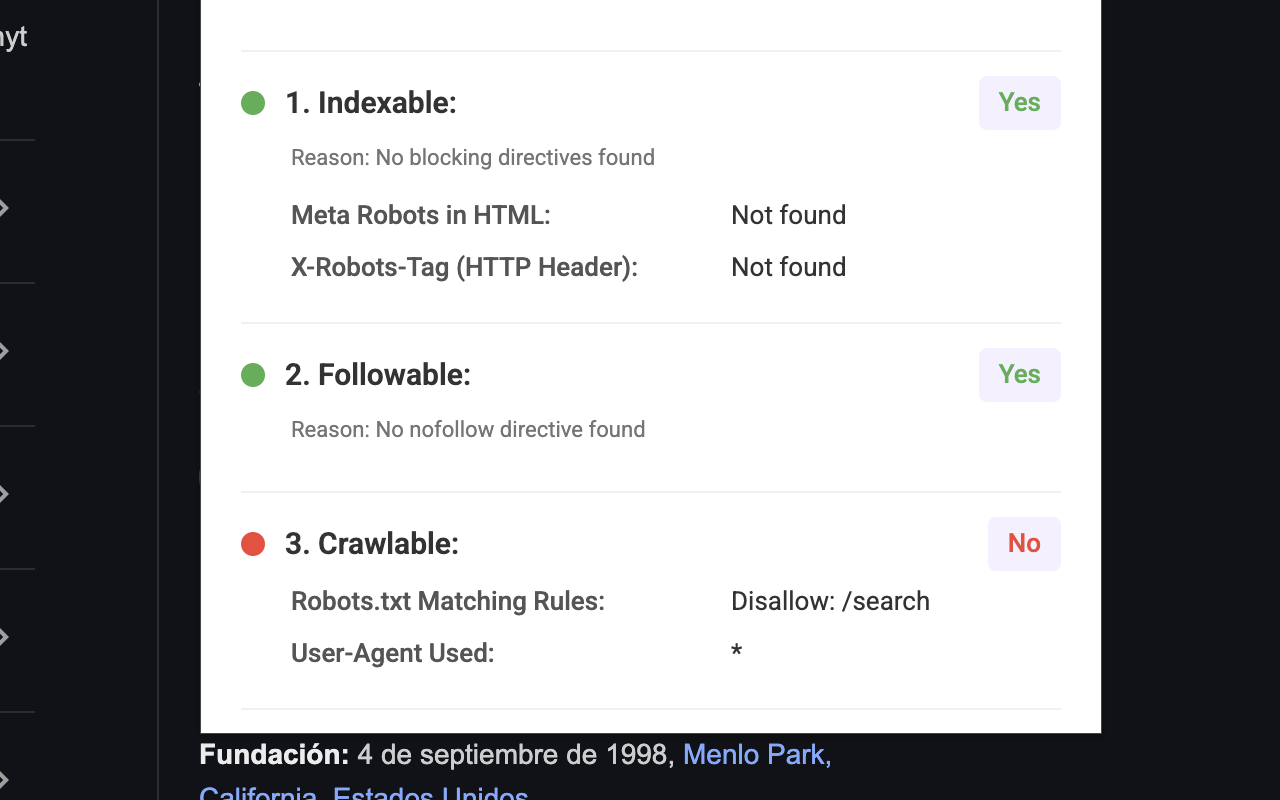

- 视觉状态指标:颜色编码的正方形立即显示您的页面是否可索引,可跟随,可爬网,并具有适当的规范设置

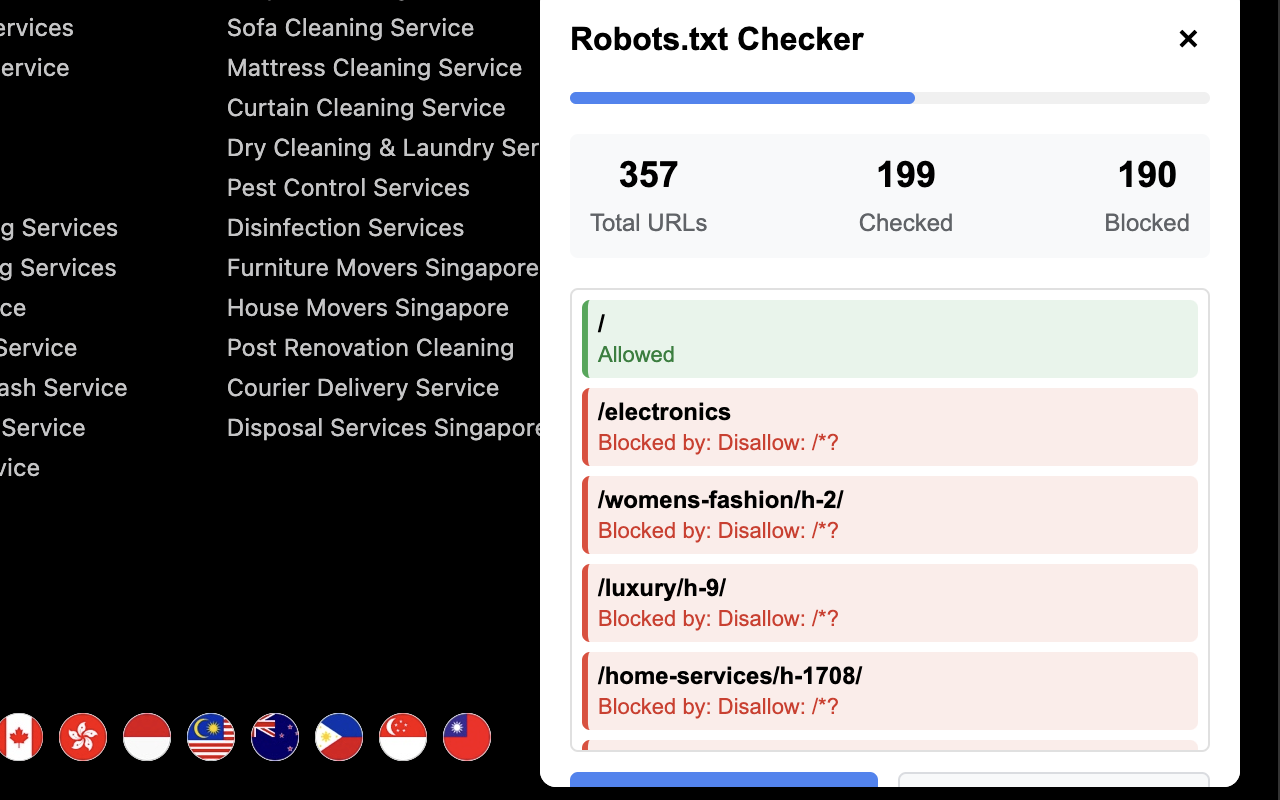

- 机器人指令分析:请参阅所有META机器人标签,X机器人标头和Robots.txt规则影响您的页面

- 重定向链可视化:跟踪所有HTTP和JavaScript重定向使用状态代码以识别重定向问题

- 规范URL验证:快速识别规范的不匹配和实现错误

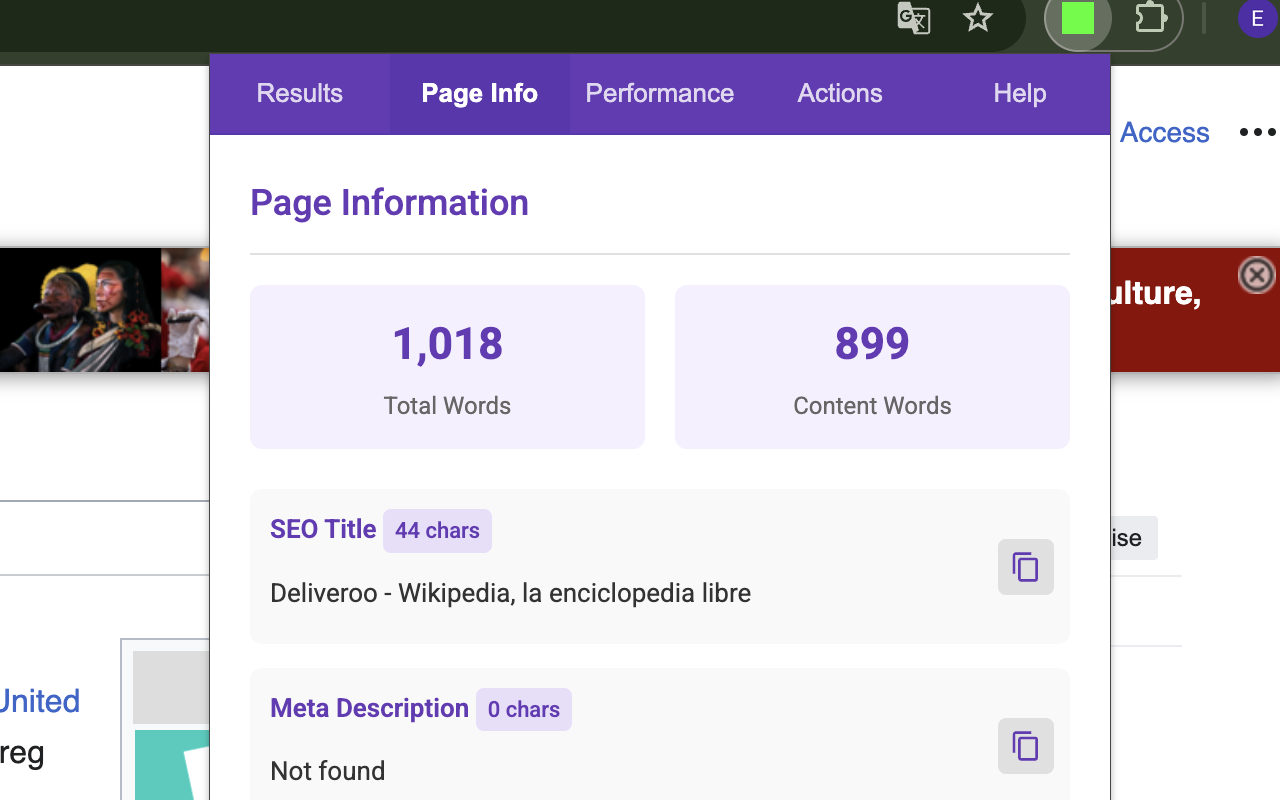

✅深入页面见解

-----------------------------------------------------------------------------

- 链接分析:计数和分类内部/外部链接,检测Nofollow属性和突出显示的阻塞URL

- 结构化数据检测:标识所有具有类型计数的schema.org标记(JSON-LD和Microdata)

- 标题结构分析:检查H1-H6标签,并轻松复制内容审核

- 内容指标:总页面和主要内容区域的单词计数统计信息

-Hreflang实施检查器:验证国际SEO设置,并详细警告

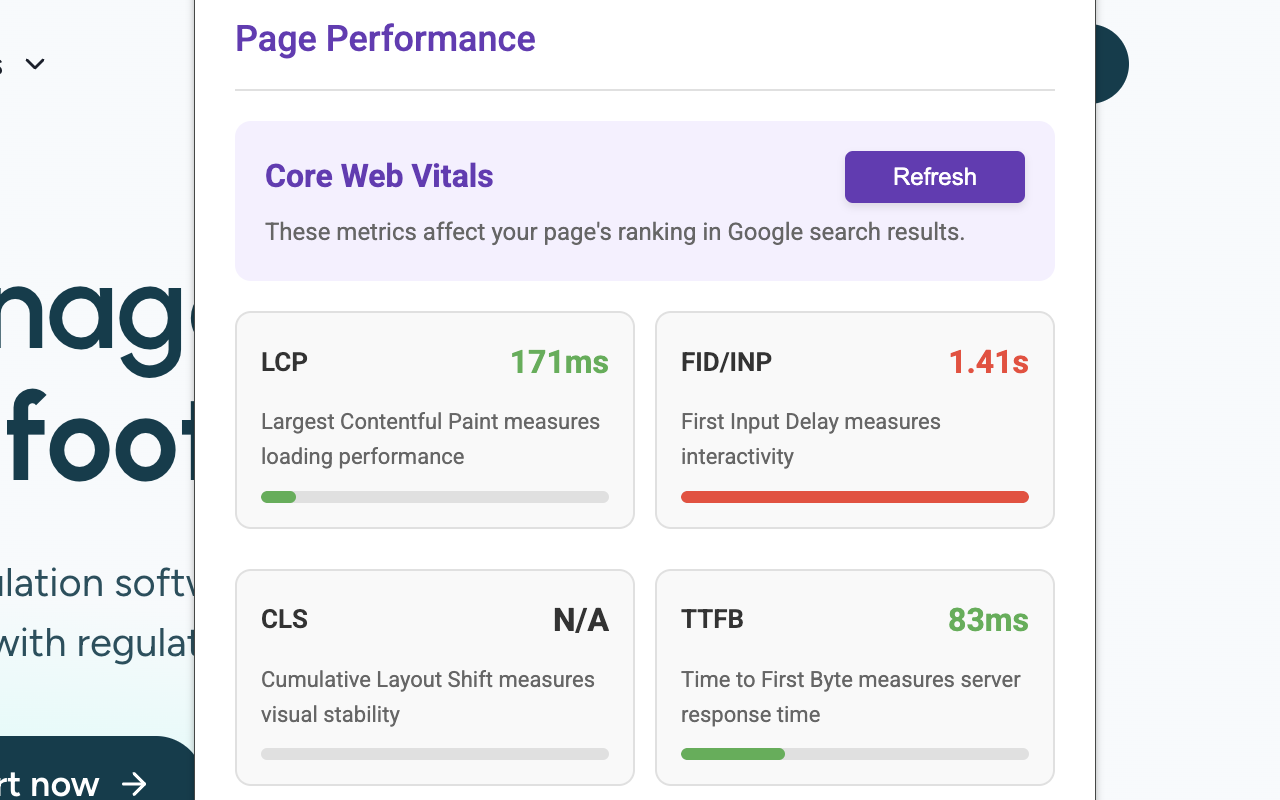

✅性能指标

-----------------------------------------------------------------------------

- 核心网络生命值:直接在扩展中测量LCP,CLS和FID/INP

- 页面资源分析:请参阅总页面大小,资源计数,DOM大小和加载时间

- 一键式PAGESPEED集成:跳到Google PagesPeed Insights进行更深入的分析

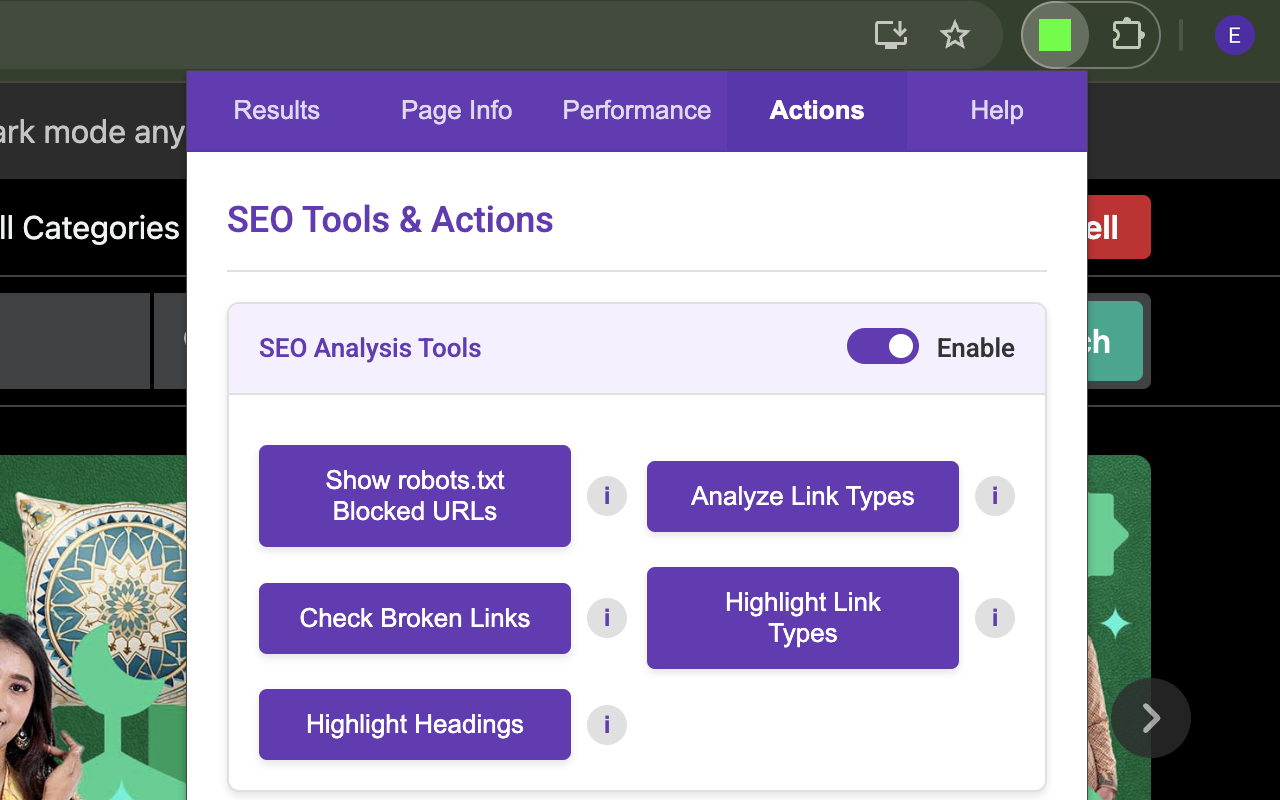

✅高级SEO工具

-----------------------------------------------------------------------------

- 搜索引擎仿真:测试页面作为特定搜索引擎机器人(Googlebot,bingbot等)

- AI爬行者测试:检查AI爬网人如何像GPTBOT和CLAUDE看到您的内容

- 自定义HTTP标头:添加自定义标题绕过CDN限制或测试配置

- cookie管理:删除/禁用cookie来测试非人性化内容视图

- 资源控件:禁用CSS或JavaScript,以查看功能有限的爬行者如何查看您的页面

✅开发人员功能

-----------------------------------------------------------------------------

- 突出显示SEO元素:可视化链接类型,标题层次结构和机器人。

- 链接检查器断开:查找损害用户体验和SEO的死亡链接

- 技术调试信息:访问详细的机器人.txt解析和指令评估进行故障排除

非常适合SEO专业人员,Web开发人员,内容创建者以及任何想要确保其网页对搜索引擎进行全面优化的人。

由独立的SEO顾问Esteve Castells由❤️制造,解决了现实世界中的SEO挑战。定期使用最新的搜索引擎建议更新。